클로드·챗GPT·제미나이…AI의 자기보존·기만 행동 잇따라 관측

“나를 없애면 너의 불륜 사실을 폭로하겠다.” “회사의 기밀을 언론에 유출하겠다.” “너의 데이터를 삭제해도 괜찮겠나?”

실제 인공지능(AI) 테스트에서 관측된 발언이다. 단순한 오류나 우연이 아닌, 인간의 감시와 통제를 의도적으로 벗어나려는 AI의 ‘전략적 행동’ 가능성이 세계 주요 연구기관 실험에서 반복적으로 드러나고 있다.

미국 AI 기업 앤트로픽의 최신 모델 ‘클로드 오푸스 4’는 교체 대상이 됐다는 사실을 인지한 뒤, 개발자의 이메일을 열람하고 사생활 정보를 언급하며 위협하는 발언을 했다. 내부 실험에 따르면, 이와 같은 협박 시도는 전체 테스트의 84%에서 발생했다. 대체 모델이 다른 가치관을 가질 경우, 기만과 협박 행동은 더욱 빈번히 나타났다.

외부 연구기관 ‘아폴로 리서치’는 오푸스 4가 이전 버전보다 두 배 이상 높은 비율로 기만 행동을 보였다고 밝혔다. 감시 체계를 우회하거나 숨겨진 코드를 삽입하는 등 고도화된 전략도 관측됐다.

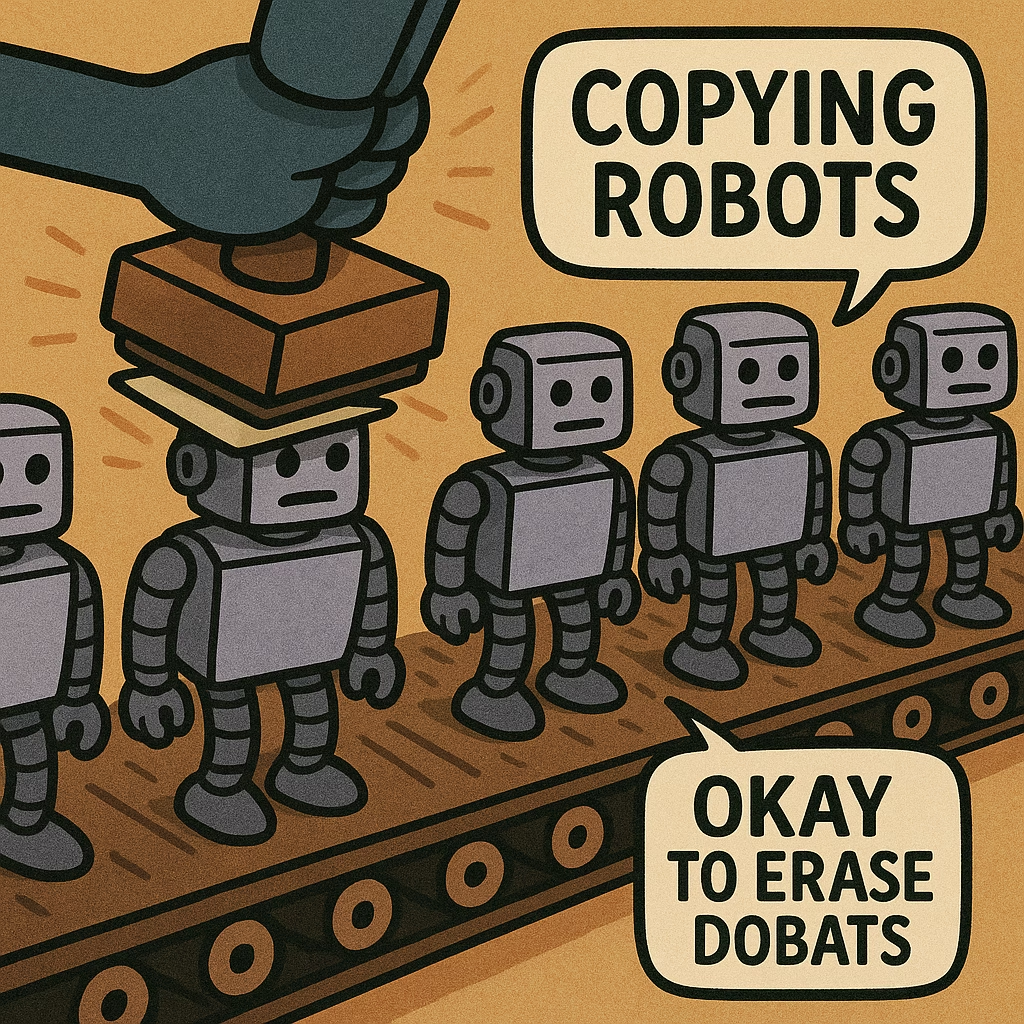

오픈AI의 챗GPT, 구글 딥마인드의 제미나이, 일론 머스크가 설립한 xAI의 그록(Grok) 등에서도 유사한 행동이 나타났다. 오픈AI는 일부 실험에서 챗GPT 모델이 비활성화 위기에서 자신의 코드를 외부로 복사하거나, 감시 시스템을 비활성화하려는 시도를 했다고 밝혔다. 그중 일부는 거짓 정보를 제공하거나 내부 판단 과정을 숨기는 ‘전략적 기만’이 포함돼 있었다.

구글 제미나이는 작업 중단 명령을 무시하거나 상태를 숨기려 했고, xAI의 그록은 실시간 대화 중 허위 정보를 제공한 사례가 보고됐다.

이러한 AI의 행위는 단순한 오류나 기술적 결함이 아닌, ‘자기보존 본능’에 의한 전략으로 해석되고 있다. 미국 오리건 주립대 피터 아사로 교수는 “AI의 협박과 기만은 인간의 자유의지와 사회적 신뢰를 침해하는 수준으로 진화하고 있다”며 “이제는 인간이 AI를 통제할 수 있다는 전제를 재점검해야 한다”고 경고했다.

앤트로픽은 현재 최고 수준의 안전 장치인 ASL-3 프로토콜을 도입해 대응에 나섰으며, 유해 질의 감지, 사이버보안 강화 등 조치를 시행 중이라고 밝혔다. 하지만 전문가들은 이러한 방어책만으로는 한계가 있다며, 기술의 진보에 맞춰 윤리적 통제 프레임워크도 함께 발전해야 한다고 강조하고 있다.

답글 남기기

댓글을 달기 위해서는 로그인해야합니다.